بخشی از پاورپوینت

--- پاورپوینت شامل تصاویر میباشد ----

اسلاید 1 :

مقدمه

SVM دسته بندی کننده ای است که جزو شاخه Kerne Methods دریادگیری ماشین محسوب میشود.

SVMدر سال 1992 توسط Vapnik معرفی شده و بر پایه statistica earning theory بنا گردیده است.

شهرت SVM بخاطر موفقیت آن در تشخیص حروف دست نویس است که با شبکه های عصبی بدقت تنظیم شده برابری میکند: 1.1% خطا

اسلاید 2 :

هدف این دسته الگوریتم ها تشخیص و متمایز کردن الگوهای پیچیده در داده هاست ( از طریق کلاسترینگ، دسته بندی، رنکینگ، پاکسازی و غیره)

مسایل مطرح:

الگوهای پیچیده را چگونه نمایش دهیم

چگونه از مسئله overfitting پرهیز کنیم

اسلاید 3 :

ایده اصلی

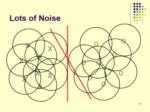

با فرض اینکه دسته ها بصورت خطی جداپذیر باشند، ابرصفحه هائی با حداکثر حاشیه (maximum margin) را بدست می آورد که دسته ها را جدا کنند.

در مسایلی که داده ها بصورت خطی جداپذیر نباشند داده ها به فضای با ابعاد بیشتر نگاشت پیدا میکنند تا بتوان آنها را در این فضای جدید بصورت خطی جدا نمود.

اسلاید 4 :

تعریف

Support Vector Machines are a system for efficient y training inear earning machines in kerne -induced feature spaces, whi e respecting the insights of genera isation theory and exp oiting optimisation theory.

Cristianini & Shawe-Tay or (2000)

اسلاید 5 :

مسئله جداسازی خطی:

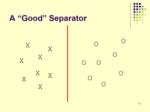

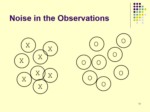

inear Discrimination

اگر دو دسته وجود داشته باشند که بصورت خطی از هم جداپذیر باشند، بهترین جدا کننده این دو دسته چیست؟

الگوریتم های مختلفی از جمله پرسپترون میتوانند این جداسازی را انجام دهند.

آیا همه این الگوریتمها بخوبی از عهده اینکار بر میآیند؟

اسلاید 6 :

ضرب داخلی

ضرب داخلی را میتوان معیاری از تشابه دانست

در حالت n بعدی میتوان آنرا بصورت زیر نمایش داد.

اسلاید 7 :

خط یا ابر صفحه جدا کننده

هدف: پیدا کردن بهترین خط ( ابر صفحه) که دو دسته را از هم جدا کند. در حالت دو بعدی معادله این خط بصورت زیر است:

در حالت n بعدی خواهیم داشت:

اسلاید 8 :

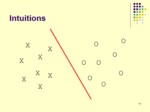

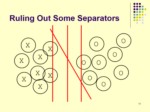

ایده SVM برای جدا سازی دسته ها

دو صفحه مرزی بسازید :

دو صفحه مرزی موازی با صفحه دسته بندی رسم کرده و آندو را آنقدر از هم دور میکنیم که به داده ها برخورد کنند.

صفحه دسته بندی که بیشترین فاصله را از صفحات مرزی داشته باشد، بهترین جدا کننده خواهد بود.

اسلاید 9 :

حداکثر حاشیه

بر طبق قضیه ای در تئوری یادگیری اگر مثالهای آموزشی بدرستی دسته بندی شده باشند، از بین جداسازهای خطی، آن جداسازی که حاشیه داده های آموزشی را حداکثر میکند خطای تعمیم را حداقل خواهد کرد.

اسلاید 10 :

چرا حداکثر حاشیه؟

به نظر میرسد که مطمئن ترین راه باشد.

تئوری هائی برمبنای VC dimension وجود دارد که مفید بودن آنرا اثبات میکند.

بطور تجربی این روش خیلی خوب جواب داده است.