بخشی از پاورپوینت

یادگیری تقویتی

در یک مسئله یادگیری تقویتی با عاملی روبرو هستیم که از طریق سعی و خطا با محیط تعامل کرده و یاد میگیرد تا عملی بهینه را برای رسیدن به هدف انتخاب نماید.

یادگیری تقویتی از اینرو مورد توجه است که راهی برای آموزش عاملها برای انجام یک عمل از طریق دادن پاداش و تنبیه است بدون اینکه لازم باشد نحوه انجام عمل را برای عامل مشخص نمائیم.

دو استراتژی اصلی برای اینکار وجود دارد:

یکی استفاده از الگوریتم های ژنتیکی

و دیگری استفاده از روشهای آماری و dynamic programming

در RL روش دوم مد نظر است.

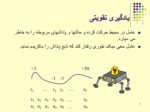

محیط مجموعه ای از S حالت ممکن است.

در هر لحظه t عامل میتواند یکی از A عمل ممکن را انجام دهد.

عامل ممکن است در مقابل عمل و یا مجموعه ای از اعمالی که انجام میدهد پاداش r را دریافت کند. این پاداش ممکن است مثبت و یا منفی )تنبیه(باشد

عامل در محیط حرکت کرده و حالتها و پاداشهای مربوطه را به خاطر می سپارد.

عامل سعی میکند طوری رفتار کند که تابع پاداش را ماکزیمم نماید.

عامل در محیط حرکت کرده و حالتها و پاداشهای مربوطه را به خاطر می سپارد.

عامل سعی میکند طوری رفتار کند که تابع پاداش را ماکزیمم نماید.

پاداش Rt مجموع پاداشی است که عامل با گذشت زمانt جمع کرده است.

فرض می کنیم که اعمال عامل از قانونی مثل p تبعیت میکند که آنرا خط مشی و یا policy می نامیم.

از آنجائیکه Rt یک متغیر تصادفی است لذا امید ریاضی آن تحت یک خط مشی خاص و برای یک حالت معین برابر خواهد بود با:

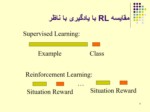

یادگیری تقویتی از دو جنبه با یادگیری با ناظر تفاوت دارد:

مثالهائی یادگیری بصورت زوج >ورودی خروجی< مطرح نمیشوند. بلکه بعد از اینکه عامل عملی را انجام داد پاداشی را دریافت میکند و به مرحله بعدی میرود.عامل هیچ گونه اطلاعی در مورد اینکه در هر حالت بهترین عمل چیست را ندارد. بلکه این وظیفه عامل است که در طول زمان تجربه کافی در مورد حالتها، عمل های ممکن، انتقال و پاداش جمع آوری نموده و عملکرد بهینه را یاد بگیرد.

تفاوت دیگر در اینجاست که سیستم باید کارائی آنلاین بالائی داشته باشد. زیرا اغلب ارزیابی سیستم با عمل یادگیری بطور همزمان صورت میپذیرد.

همانگونه که گفته شد یک تفاوت اساسی میان یادگیری تقویتی و یادگیری با ناظردر این است که در یادگیری تقویتی عامل مجبور به جستجوی محیط است. در اینگونه مسائل با این سوال روبرو هستیم که وقتی که عامل در حالتی قرار میگیرد که پاداش مناسبی دریافت میکند آیا باید جستجو برای حالتهای بهتر را ادامه دهد و یا باید در همان مرحله متوقف شود.؟

تکنیکهای متفاوتی برای اینکار معرفی شده است از جمله:

Dynamic Programming

Learning Automata

Adaptive control

یادگیری تقویتی با ترکیب تکنیک Dynamic Programming با یادگیری با کمک ناظر به حل مسئله میپردازد.